李航博士:人工智能需要新的计算范式和理论

2022年11月17日上午,字节跳动科技有限公司研究部门负责人.ACL会士,IEEE 会士,ACM 杰出科学家李航博士受12BET邀请,通过线上形式为“12BET智能科学前沿论坛”带来了一场精彩的报告,报告题目为“人工智能需要新的计算范式和理论” ,吸引了包括12BET,人工智能研究院,王选所和计算机学院的众多老师和同学们的参与。

李航博士首先从人工智能的最新动态出发,通过介绍工业界研发的若干主要技术来引出探讨人工智能需要怎样的计算范式和计算理论的问题。

在当前人工智能领域的前沿研究中,图像、语音、语言等载体处理上的区别更多在于数据格式上,例如现在基于Transformer的模型可以用于很多种形式的数据上。预训练、自监督学习等方法也显得越加重要。此外,人工智能也正在渐渐扩展到AI for Science等新领域。

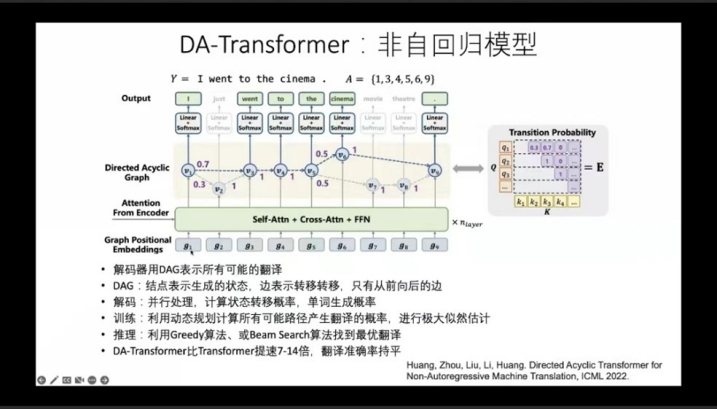

工业界AI Lab在多种形式的数据上都实现了与其相适应的有效的模型,包括非自回归模型DA-Transformer、端到端语音到文本翻译ConST、多颗粒度的视觉语言模型X-VLM、图片和文本统一生成模型DaVinci和语言理解模型Neural Symbolic Processor等。

李航博士指出,人工智能领域可能需要一些新的计算范式,其中脑启发计算可能是一个有价值的未来研究点。脑启发计算参考人脑的机制构建机器的学习和推理智能系统,主要着力于解决样本效率、能源效率、逻辑推理等方面的问题。人的大脑都是分区运作的,其中包括类推推理区和逻辑推理区。我们希望未来的人工智能模型在能根据现有数据集进行类推推理的同时,能够有一些先天的能力进行合理的逻辑推理。

在人工智能的计算理论上,目前理论研究的主要问题包括泛化能力、优化能力、稳健性和可解释性等。李航分别对信息瓶颈理论和编码率降低最大化原理进行介绍,并指出当今热门的Transformer架构是自注意力网络的集成,如果仅采用此模块会造成模型的退化。未来可以基于信息流、数据结构和函数表示等方向进行研究。

报告最后李航博士耐心回答了线上老师与同学们关于此次报告内容的一些问题,林宙辰教授对李航博士分享的精彩报告进行了总结与感谢,本次交流报告分享活动至此圆满结束。

地址:北京市海淀区颐和园路5号(62755617) 反馈意见:its@pku.edu.cn

Copyright 版权所有©12BET - Sports Betting Winners All Rrights Reserved.